Se ha publicado una hoja de problemas (algoritmos de ramificación y poda).

Desde hoy, 9 de mayo, hasta el prĂłximo dĂa 30, estĂĄ abierto el periodo de realizaciĂłn de encuestas sobre la docencia de la asignatura:

Las encuestas son muy importantes para facilitar la mejora, año a año, de la asignatura. Os rogamos dediquéis unos minutos de vuestro tiempo para responderlas.

El curso pasado alcanzamos un 72.73% de respuestas en esta asignatura. Nos gustarĂa igualar o superar esa cifra.

En la transparencia 55 de programaciĂłn dinĂĄmica quedĂł como ejercicio el cĂĄlculo de los nodos de las secuencias que componen los caminos mĂnimos desde cualquier nodo i a cualquier nodo j. Hay varias formas de resolverlo. Una muy sencilla consiste en guardar una matriz adicional C[v,w] en la que se almacene un nodo u que estĂ© en el camino mĂnimo de v a w. Para ello, en el interior de los tres bucles del algoritmo, hay que modificar la instrucciĂłn condicional añadiendo la actualizaciĂłn de esa matriz C:

si D[i,k]+D[k,j]<D[i,j] entonces

D[i,j]:=D[i,k]+D[k,j];

C[i,j]:=k

fsi

La matriz se ha debido inicializar al principio del algoritmo (por ejemplo con valores nulos). El algoritmo para el cĂĄlculo del camino mĂnimo de i a j, usando la matriz C, queda como:

procedimiento camino(ent i,j:vértice;

ent C:vector[vértice,vértice] de entero)

variable k:vértice

principio

k:=C[i,j];

si kâ 0 entonces

camino(i,k,C);

escribir(k);

camino(k,j,C)

fsi

fin

Se han publicado en Moodle.

.

Las soluciones de programaciĂłn dinĂĄmica aparecen en prĂĄcticamente todos los dominios de aplicaciĂłn. Seleccionamos aquĂ algunos ejemplos en VisiĂłn, Juegos, RobĂłtica y BioinformĂĄtica:

Uno de los ejemplos mås sencillos (mås que los vistos en clase) de aplicación de la programación dinåmica es el cålculo del término n-ésimo de la sucesión de Fibonacci.

La definiciĂłn de la sucesiĂłn o funciĂłn de Fibonacci es:

Fib(n) = 1, si n = 0,1

Fib(n) = Fib(n-1) + Fib(n-2), si n > 1

La soluciĂłn mĂĄs natural para calcular el tĂ©rmino n-Ă©simo serĂa, por tanto, traducir esa definiciĂłn recursiva de la funciĂłn a nuestro pseudocĂłdigo:

funciĂłn FibRec(n:natural) devuelve natural

principio

si nâ€1 entonces

devuelve 1

sino

devuelve FibRec(n-1)+FibRec(n-2)

fsi

fin

El inconveniente de esa soluciĂłn es su coste, exponencial en el valor de n. La ineficiencia de FibRec se debe a que se producen llamadas repetidas de la funciĂłn para calcular valores que ya se habĂan calculado previamente, no se ha conservado su resultado, y por tanto hay que volver a calcularlos.

La soluciĂłn de programaciĂłn dinĂĄmica pasarĂa por utilizar una tabla auxiliar en la que almacenar las soluciones de todos los “subproblemas” (valores de Fib para valores menores que n) resueltos:

El algoritmo iterativo para devolver el n-Ă©simo tĂ©rmino de Fibonacci calculando la tabla serĂa:

funciĂłn FibIterProto(n:natural) devuelve natural

variables i:natural; T:vector[0..n] de natural

principio

si nâ€1 entonces

devuelve 1

sino

T[0]:=1;

T[1]:=1;

para i:=2 hasta n hacer

T[i]:=T[i-1]+T[i-2]

fpara;

devuelve T[n]

fsi

fin

El Ășltimo paso en la mejora proviene de detectar que en el algoritmo anterior no es necesario todo el vector auxiliar, pues basta con almacenar los dos Ășltimos valores calculados:

funciĂłn FibIter(n:natural) devuelve natural

variables i,suma,x,y:natural {x e y para almacenar los dos Ășltimos

términos calculados y suma para almacenar el actual}

principio

si nâ€1 entonces

devuelve 1

sino

x:=1;

y:=1;

para i:=2 hasta n hacer

suma:=x+y;

y:=x;

x:=suma

fpara;

devuelve suma

fsi

fin

Se ha publicado una hoja de problemas (algoritmos de programación dinåmica).

La prueba escrita intermedia (prevista en la guĂa docente) serĂĄ el miĂ©rcoles 29 de marzo a las 15:00 (duraciĂłn: 2 horas) en el aula 12 del edificio Ada Byron.

ConsistirĂĄ en un par de problemas de los temas de algoritmos voraces y divide y vencerĂĄs.

Se permitirĂĄ utilizar material impreso (transparencias, librosâŠ) pero no se permitirĂĄ el uso de dispositivos electrĂłnicos (telĂ©fonos, tabletas, etc).

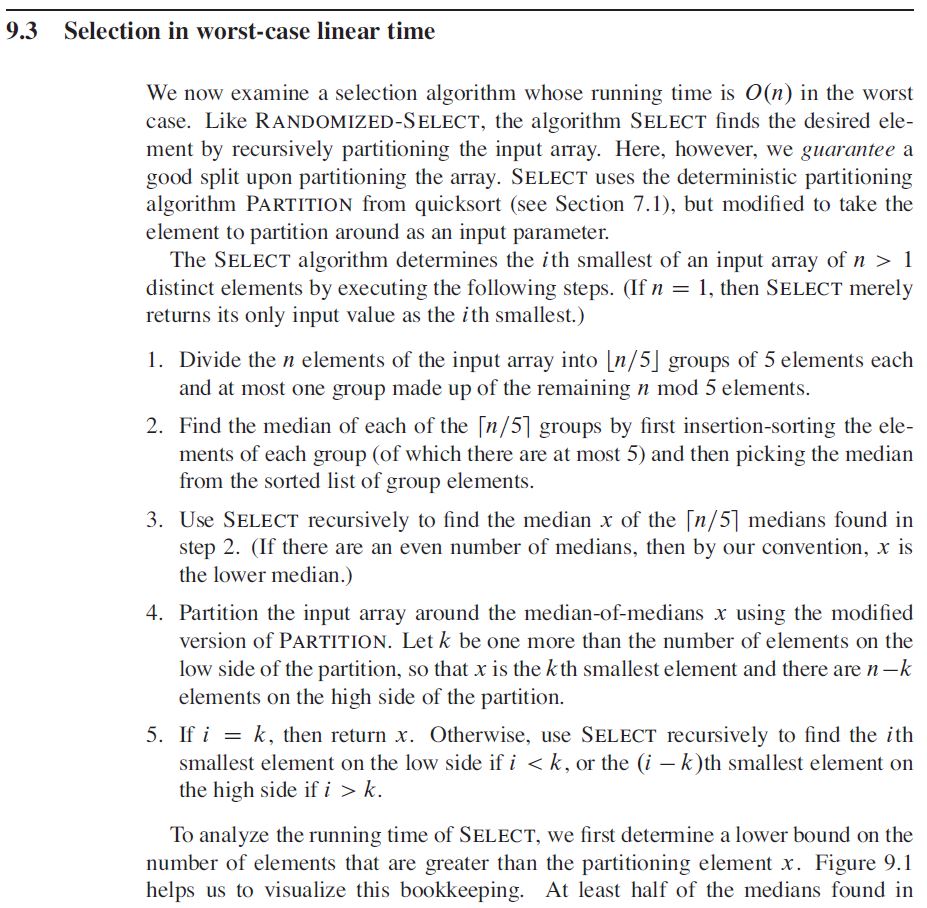

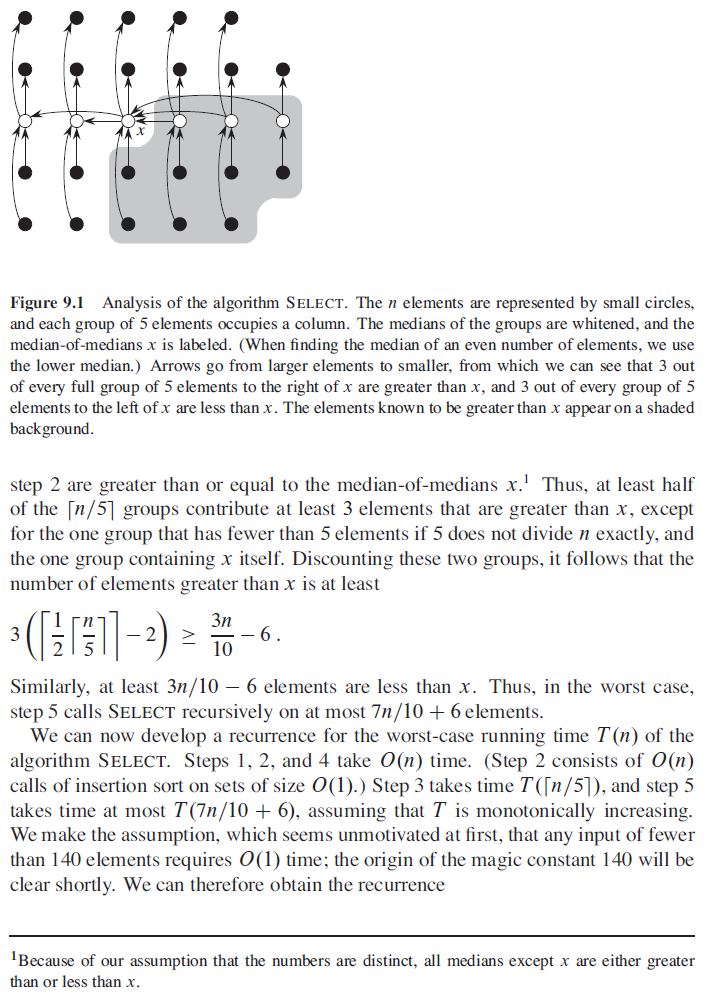

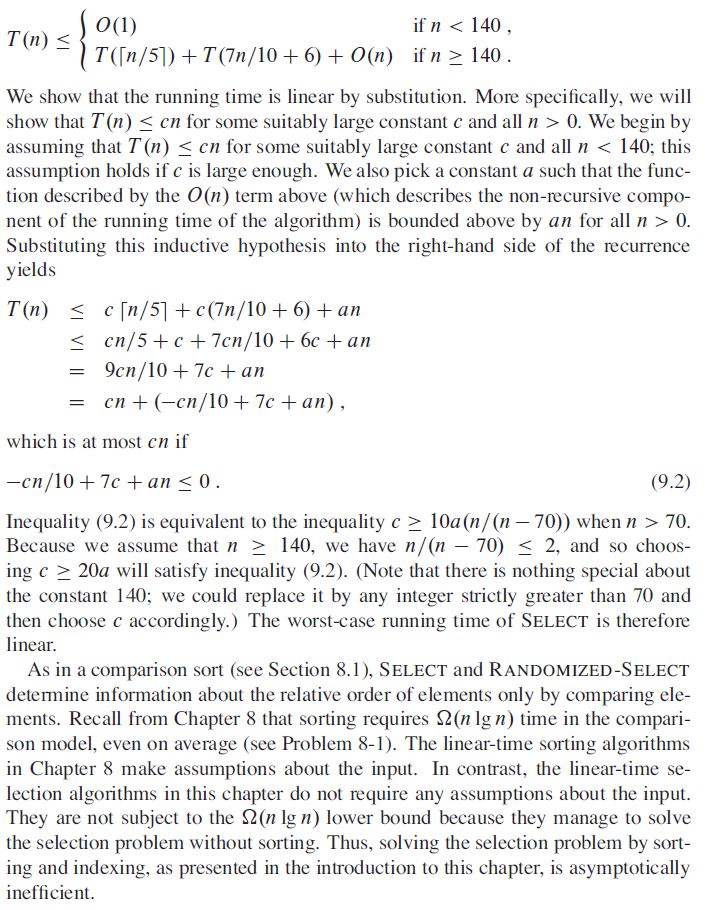

Existe un algoritmo de coste asintĂłtico lineal, en el caso peor, para el problema de selecciĂłn, es decir, para el cĂĄlculo del k-Ă©simo menor elemento (o estadĂstico de orden k) de un vector de tamaño n. Por tanto, en particular, puede usarse para el cĂĄlculo de la mediana (haciendo k = techo(n/2) ).

Os lo incluyo debajo, extraĂdo del libro Introducion to Algorithms, de Cormen, Leiserson, Rivest y Stein.

Una vez se dispone de un algoritmo de coste lineal (caso peor) para el cålculo de la mediana, existe una modificación del algoritmo quicksort que tiene coste O(n logn) en el caso peor. Consiste en elegir la mediana como el pivote que se utiliza para la partición del vector en dos trozos, en cada llamada recursiva del quicksort.

.

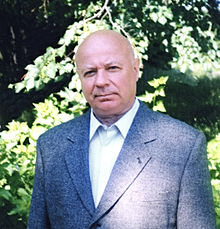

El algoritmo conocido como “de Karatsuba y Ofman” para multiplicar enteros de n cifras con un coste asintĂłtico en O(nlog 3)  ( â O(n1,59) )  aparece publicado en el artĂculo ”Multiplication of multidigit numbers on automata”, A. Karatsuba, Y. Ofman, en el nÂș 145, pp. 293-294, de las actas de la Academia de Ciencias de la extinta UniĂłn SoviĂ©tica (Doklady Akademii Nauk SSSR) en 1962.

Curiosamente, el mencionado artĂculo no fue escrito por Anatoli AleksĂ©yevich Karatsuba (Grozny, URSS, 31 de enero de 1937 â MoscĂș, Rusia, 28 de septiembre de 2008) sino que, tal y como relata Ă©l mismo en su artĂculo “The complexity of computations” (publicado en Proceedings of the Steklov Mathematical Institute, vol. 211, pp. 169-183, 1995, copia local con clave aquĂ), fue escrito por Kolmogorov, probablemente ayudado por Ofman, y sin el conocimiento de Karatsuba, quien era realmente el autor del algoritmo:

[...] Later in 1962 Kolmogorov wrote a short article (probably in collaboration with Ofman) and published it in Doklady Akad. Nauk SSSR. The article was entitled: A. Karatsuba and Y. Ofman, “Multiplication of Multiplace Numbers on Automata” (Doklady Akad. Nauk SSSR, vol. 145, No. 2, pp. 293-294). I learned about the article only when I was given its reprints.

En el mismo artĂculo de 1995, Karatsuba reivindica su autorĂa:

In this section I present my algorithm for multiplying numbers. Now it is called the KML algorithm or, briefly, KML (Karatsuba Multiplication).

Con posterioridad, se han desarrollado algoritmos asintĂłticamente mĂĄs rĂĄpidos que el de Karatsuba, como el de SchönhageâStrassen (1971), de coste Î(n log(n) log(log(n))), o el de Martin FĂŒrer (2007), de coste n log(n) 2Î(log*(n)).