Aquí puedes encontrar unas propuestas para Trabajos de Fin de Grado/Máster. Para más información sobre estos proyectos contactar con Rubén Martínez rmcantin@unizar.es

Feature Fusion Fields for Environment Understanding

Los métodos de redes neuronales pueden utilizarse tanto para la representación geométrica (p. ej., NeRF) como para la semántica (p. ej., CLIP). Hemos desarrollado un método que combina lo mejor de ambos mundos para vídeos egocéntricos. La idea de estas prácticas es ampliar el método para incorporar nuevas modalidades como el sonido, en lugar del texto, o hacer el aprendizaje en línea utilizando SLAM.

Geometric/Semantic understanding for Prosthetic Vision

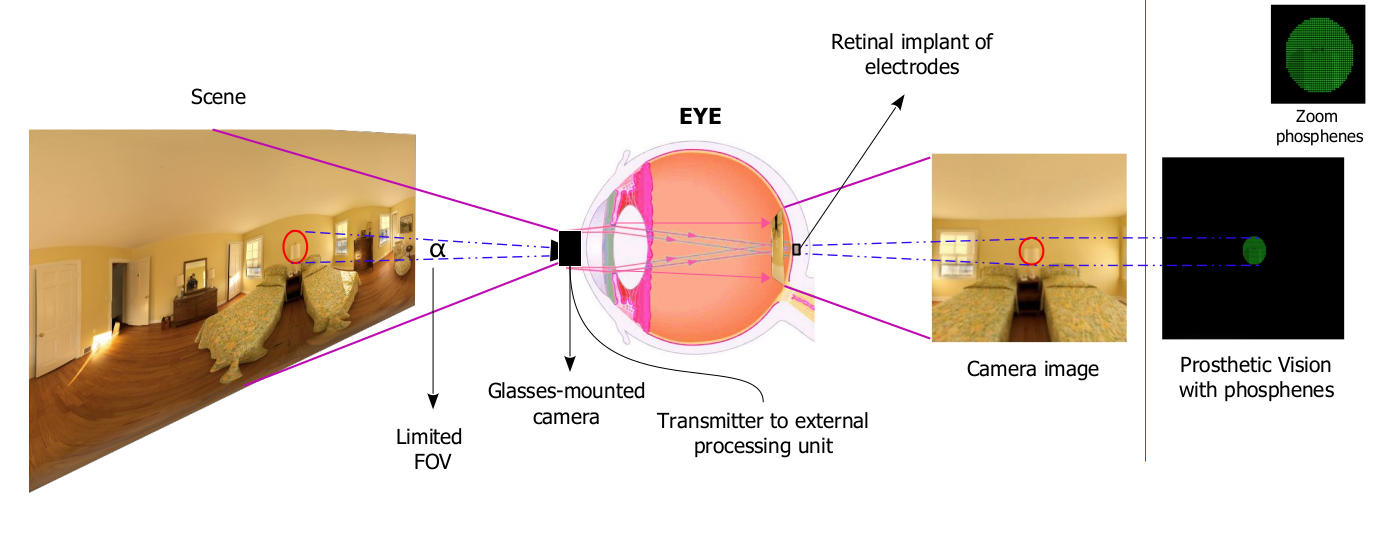

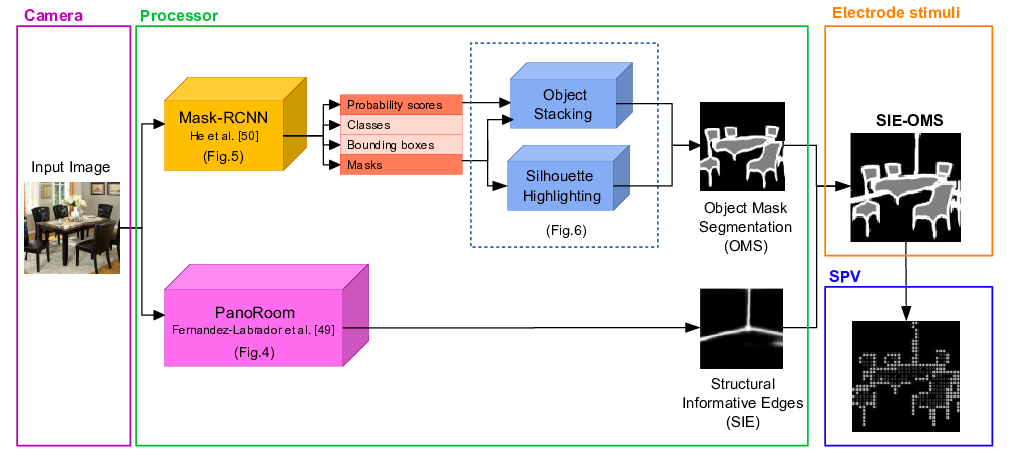

La ceguera y la discapacidad visual son grandes problemas sociales. Recientemente, están apareciendo prótesis visuales (retinianas o corticales) y gafas inteligentes que pueden recuperar parcialmente la percepción visual para muchos tipos de discapacidad. Estamos desarrollando herramientas para incorporar IA (aprendizaje profundo y visión por computador) para que esos sistemas sean más inteligentes y proporcionen más información al usuario. En este proyecto, la idea es integrar nuestros resultados sobre campos de fusión de características (ver propuesta anterior) en una plataforma de visión protésica simulada y evaluar el rendimiento de esos métodos para ayudar a usuarios ciegos.

Self-supervised depth estimation with uncertainty

Hemos desarrollado el primer método de estimación de profundidad con una sola vista, auto-supervisado (sin supervisión externa) en endoscopios, llamado LightDepth. En la mayoría de vistas funciona bastante bien, sin embargo, no existen garantías de su funcionamiento en datos muy diferentes de los de entrenamiento (llamados out-of-distribution) y pueden generar alucinaciones. Estos datos pueden ser los más relevantes en medicina ya que se corresponden con lesiones o enfermedades a tener en cuenta. Por otro lado, los métodos de aprendizaje Bayesiano son capaces de gestionar la incerteza asociada con el modelo, alertando al médico o endoscopista de si las predicciones son fiables o no y requieren más información. El objetivo de este proyecto es integrar y evaluar técnicas de aprendizaje Bayesiano en LigthDepth y cómo explotar la estimación de incerteza para mejorar la estimación.

Algunos trabajos previos:

Bayesian 6D Object Pose Estimation

In order to interact with their environments, autonomous robots need to estimate the 3D pose of the surrounding objects. This is a more challenging task than the typical object detection in an image, since we need to create a 3D bounding box around the object with the adequate rotation. Furthermore, cameras do not provide by themselves the depth of each pixel, so novel techniques like neural networks can be used to estimate this magnitude. While current state-of-the-art 6D object detectors produce deterministic estimations, in this work we want to extend this task to produce a probabilistic 3D detection using deep learning methods. This means that we not only estimate the pose, but also the respective variance of the translation and rotation terms of the 3D bounding box. More information can be found: https://docs.google.com/document/d/1DGMaV2c8-XnliWtfyUg-P2My0DbKjWAPP2AxjUHyspU/edit?usp=sharing

Simulación de prótesis retinales utilizando realidad virtual

Ciertos tipos de ceguera se están recuperando parcialmente gracias a implantes retinales, que sustituyen el tejido dañado. Sin embargo, estos implantes sólo permiten ver pequeños puntos de luz (fosfenos). Se está trabajando en métodos de visión por computador y aprendizaje automático (deep learning) para mejorar la calidad de los implantes.

El trabajo consiste en el desarrollo de un simulador de prótesis retinales utilizando gafas de realidad aumentada para permitir la evaluación en personas sanas. El simulador se diseñará multiplataforma (Windows, Linux...) utilizando OpenVR, fácilmente configurable y con un interfaz para integrar métodos de visión y aprendizaje. Además, se integrará con procesamiento de imagen basado en aprendizaje profundo (deep learning) que se ha desarrollado para mejorar la visión de los pacientes implantados. Se parte de trabajos previos de simulación en Windows.

Auto-ML: Algoritmos que aprenden a aprender

Auto-ML (Automated Machine Learning) es el conjunto de técnicas que permiten automatizar el proceso de despliegue de algoritmos de aprendizaje, desde los datos crudos hasta los modelos ya entrenados. Concretamente en este trabajo se van a utilizar modelos de aprendizaje profundo (deep learning), estudiando la automatización del proceso de entrenamiento (hyperparameter tuning) como la búsqueda del modelo (neural architecture search). Es posible que este proyecto pudiera recibir financiación y se pueda realizar en colaboración con una empresa.

Control de robots con deep reinforcement learning

El aprendizaje por refuerzo profundo (deep reinforcement learning) está revolucionando la inteligencia artificial. Desde algoritmos que son capaces de ganar al campeón del mundo de Go o de Starcraft, al control de refrigeración en datacenters o la inversión en bolsa automática. En este trabajo, se investigarán algoritmos recientes de deep reinforcement learning (Deep Q-Network, Soft Actor-Critic, etc.) para el control flexible de robots.

Control de robots con optimización Bayesiana

La optimización Bayesiana se ha popularizado recientemente como una técnica de aprendizaje muy eficiente, ya que requiere un volumen de datos muy pequeño. Esto facilita el aprendizaje interactivo en tareas complejas y costosas como el control y movimiento de un robot. Se va a utilizar un software desarrollado en la universidad y que está siendo utilizado en cientos de empresas y centros de investigación. Es posible que este proyecto pudiera recibir financiación y se pueda realizar en colaboración con una empresa.

Detección automática de migración celular con deep learning

El estudio de la migración celular es fundamental para el análisis de diversos procesos fisiológicos, desde la respuesta del sistema inmune, curación de heridas, cancer y metástasis, etc. En este trabajo, se utilizan sistemas de deep learning para el reconocimiento automático y etiquetado de células migratorias y sus protrusiones usando secuencias de vídeo de microscopía multidimensional. Para más información, contactar con Rubén Martínez rmcantin@unizar.es o con María José Gómez gomezmj@unizar.es

Evaluación de benchmarks de reinforcement learning

Los algoritmos de aprendizaje por refuerzo requieren interactuar con su entorno para el aprendizaje, con lo que el control sobre entorno y las interacciones son fundamentales para evaluar la calidad de los algoritmos. Recientemente han aparecido numerosos entornos de entrenamiento (Gyms) para entrenar algoritmos de reinforcement learning y deep reinforcement learning. Estos entornos incluyen desde simuladores físicos, videojuegos clásicos (Atari) o modernos (Starcraft) hasta robots complejos. En este trabajo se plantea evaluar las diferentes opciones disponibles y plantear el diseño de benchmarks agregados.

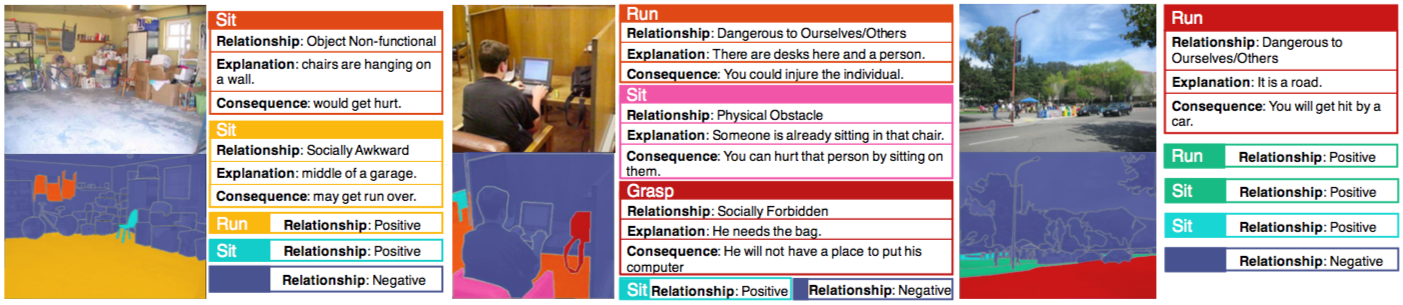

Estimación de interacciones físicas con deep learning para robots y dispositivos asistenciales

Los humanos navegan sin esfuerzo el mundo físico viendo, razonando e interactuando con los objetos que nos rodean, pero este es uno de los mayores problemas para las máquinas y robots. La teoría de percepción de affordances representa los objetos con respecto a las posibles acciones que un sujeto puede realizar y los efectos que se producen. Por ejemplo, en vez de reconocer una silla, reconocemos un objeto que podemos agarrar y desplazar, que nos podemos sentar, etc. Esto puede ser de gran utilidad en dispositivos inteligentes, que tengan que interactuar con personas o con un entorno diseñado para personas. En este proyecto se va a diseñar un sistema para reconocer estas affordances en imágenes utilizando algoritmos de aprendizaje profundo (deep learning) para aplicaciones de robótica social y de dispositivos asistenciales.